Robots.txt

Robots.txt: cos'è e come usarlo per gestire l'accesso dei motori di ricerca

Immagina di poter lasciare un biglietto all’ingresso del tuo sito, indirizzato ai motori di ricerca, con scritto chiaramente quali aree possono visitare e quali no. Questo è, in poche parole, il ruolo del file robots.txt. Un piccolo documento di testo, posizionato nella cartella principale del sito web, che comunica direttamente ai crawler – i bot automatici di Google, Bing e altri – come comportarsi durante la scansione delle pagine.

Usare correttamente il file robots.txt significa proteggere sezioni riservate, alleggerire il carico sul server e ottimizzare il modo in cui i motori di ricerca esplorano il tuo sito. È uno strumento semplice ma strategico, soprattutto quando si gestiscono grandi quantità di contenuti o si vogliono evitare indicizzazioni indesiderate.

Ma attenzione: non tutti i bot rispettano queste regole. Mentre i principali motori di ricerca tendono a seguire le indicazioni fornite nel file, alcuni crawler – specialmente quelli meno noti o malevoli – potrebbero ignorarle del tutto e accedere comunque alle aree bloccate.

Dove si trova il file robots.txt del tuo sito

Trovare il file robots.txt del proprio sito è molto più semplice di quanto sembri: basta digitare l’indirizzo completo del dominio seguito da /robots.txt nella barra del browser. Ad esempio, se il tuo sito è esempioweb.it, ti basterà scrivere: https://esempioweb.it/robots.txt.

In pochi istanti visualizzerai il contenuto del file, se presente. Questo documento risiede nella cartella principale del sito (root), accessibile pubblicamente proprio per permettere ai crawler dei motori di ricerca di leggerlo prima di iniziare la scansione delle pagine.

Lo stesso vale anche per i sottodomini. Se, ad esempio, hai un blog ospitato su blog.esempioweb.it, il file sarà visibile all’indirizzo: https://blog.esempioweb.it/robots.txt

È importante ricordare che ogni sottodominio gestisce le proprie regole in modo indipendente. Quindi, se il tuo sito utilizza più ambienti (come shop.esempioweb.it o area-riservata.esempioweb.it), ciascuno dovrebbe avere il suo file robots.txt specifico, configurato in base alle esigenze di accesso dei crawler.

Esempi pratici di file robots.txt

Il file robots.txt si basa su una struttura molto semplice, composta da due elementi fondamentali: user-agent e directive.

- Il user-agent indica a quale crawler si applica la regola (ad esempio Googlebot).

- La directive specifica cosa può o non può fare quel crawler (ad esempio disabilitare l’accesso a una cartella o a un URL).

Uno degli esempi più comuni è il blocco totale della scansione da parte di tutti i bot:

Disallow: /

In questo caso, l’asterisco * è un carattere jolly (wildcard) che rappresenta tutti i crawler. La regola sopra comunica a ogni bot di non accedere a nessuna pagina del sito.

Se invece vuoi impedire l’accesso solo a Googlebot – e lasciare che gli altri crawler esplorino il sito – userai una regola più specifica:

Disallow: /

In alternativa, puoi bloccare una sola pagina sensibile, come una login area:

Disallow: /admin-login

Oppure puoi impedire la scansione di un’intera directory, ad esempio una sezione di ricette del tuo sito:

Disallow: /recipes/

Tutte queste regole, per quanto semplici, sono estremamente potenti. Bastano poche righe per cambiare il modo in cui i motori di ricerca interagiscono con il tuo sito. Ecco perché è essenziale scriverle con attenzione, evitando errori o ambiguità.

User-agent più comuni nei file robots.txt

Ogni regola inserita nel file robots.txt inizia specificando a quale bot è destinata. Questo avviene tramite lo user-agent, ovvero il nome identificativo del crawler.

In pratica, è come scrivere il destinatario su una lettera: “Questa regola è per Googlebot”, oppure “Valida per tutti i bot”. È importante ricordare che gli user-agent sono case-sensitive, quindi vanno scritti esattamente come previsto dal motore di ricerca.

Di seguito trovi una tabella riepilogativa con i nomi dei bot più comuni e il loro significato:

| User-agent | Descrizione | Motore di ricerca |

|---|---|---|

* | Wildcard: regola applicata a tutti i crawler | Tutti |

Googlebot | Bot principale di Google per la ricerca web | |

Googlebot-Image | Bot dedicato alla scansione delle immagini | Google Immagini |

Bingbot | Bot ufficiale di Bing per l’indicizzazione dei siti | Microsoft Bing |

Slurp | Crawler utilizzato dal motore di ricerca Yahoo! | Yahoo! |

YandexBot | Crawler del motore di ricerca russo Yandex | Yandex |

GPTBot | Bot utilizzato da OpenAI per l’addestramento linguistico | OpenAI |

Le direttive più utilizzate nel file robots.txt

All’interno del file robots.txt, le direttive rappresentano le istruzioni vere e proprie che comunichiamo ai bot: cosa possono fare, dove possono andare e quali percorsi devono invece evitare. Sono comandi semplici ma potenti, in grado di influenzare il comportamento dei crawler in modo preciso.

Le più comuni sono: Disallow, Allow, Sitemap e Crawl-delay. Vediamole nel dettaglio.

Disallow

La direttiva Disallow viene utilizzata per bloccare l’accesso a determinate aree del sito. Quando un crawler incontra questa istruzione, sa che non deve visitare quelle URL.

Ad esempio, se vogliamo impedire l’accesso alla dashboard di WordPress:

Disallow: /wp-admin/

Con questa regola, i bot non tenteranno di accedere né a /wp-admin/, né a percorsi interni come /wp-admin/edit.php.

Allow

A differenza di Disallow, la direttiva Allow viene usata per consentire l’accesso a specifici percorsi, all’interno di una sezione precedentemente bloccata.

Facciamo un esempio pratico: vogliamo bloccare l’intera sezione /paid-course/, ma permettere ai crawler di esplorare una parte specifica, come la prima lezione:

Disallow: /paid-course/

Allow: /paid-course/chapter-one

Con questa regola:

- Google potrà accedere a /paid-course/chapter-one/ e alle sue sottosezioni

- Ma non accederà a /paid-course/ o a /paid-course/chapter-two/

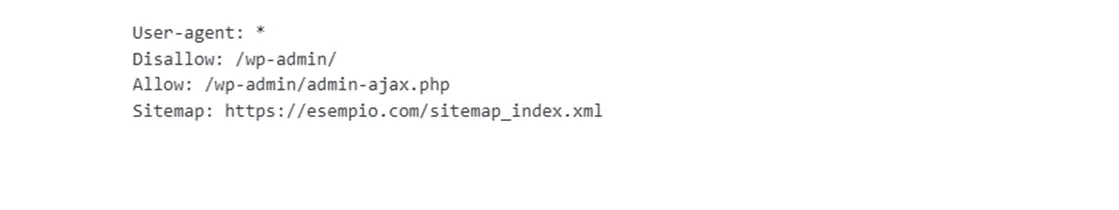

Sitemap

Con la direttiva Sitemap possiamo indicare direttamente ai motori di ricerca dove trovare la mappa XML del sito. Questo aiuta a velocizzare l’individuazione e l’indicizzazione dei contenuti.

Non è legata a uno specifico user-agent, e va scritta così:

È possibile dichiarare più sitemap, se il sito è suddiviso in varie sezioni:

Sitemap: https://tuodominio.it/page-sitemap.xml

Sitemap: https://tuodominio.it/category-sitemap.xml

Crawl-delay

La direttiva Crawl-delay serve a limitare la frequenza con cui i bot effettuano richieste al server, per ridurre il carico su siti con risorse limitate.

Va usata con cautela, anche perché non tutti i motori la rispettano: ad esempio, Google e Yandex la ignorano, mentre Bing sì.

Un esempio pratico:

Crawl-delay: 10

Alcuni crawler interpreteranno questo comando come: “Attendi 10 secondi tra una richiesta e l’altra”.

Con queste direttive, puoi controllare con precisione come e dove i motori di ricerca accedono ai tuoi contenuti. Ma attenzione: una sola riga mal scritta può cambiare completamente il comportamento del crawler.

Buone pratiche per scrivere un file robots.txt efficace

Un file robots.txt mal configurato può causare danni SEO significativi: dalla deindicizzazione accidentale di intere sezioni del sito, fino al blocco completo dell’accesso ai motori di ricerca. Per evitare errori e garantire che il file svolga correttamente la sua funzione, è utile seguire alcune regole fondamentali.

| # | Best Practice |

|---|---|

| 1 | Evita regole in conflitto Quando un file contiene molte direttive, può capitare di inserire istruzioni contraddittorie, come ad esempio:

Queste situazioni confondono i bot, che potrebbero interpretare le regole in modo imprevisto. Alcuni seguono la prima istruzione, altri quella più breve o meno restrittiva. Meglio mantenere una logica semplice e coerente. |

| 2 | Non usare robots.txt per nascondere le pagine dai motori di ricerca Bloccare un URL con Disallow non impedisce l’indicizzazione, soprattutto se ci sono link verso quella pagina altrove. Google potrebbe comunque mostrarla nei risultati.Se vuoi evitarne la presenza in SERP, usa il tag: <meta name="robots" content="noindex"> |

| 3 | Inserisci sempre la sitemap nel file robots.txt Anche se i motori di ricerca possono trovare i contenuti senza sitemap, è buona prassi indicarla chiaramente nel file robots.txt. Aiuta a scansionare meglio il sito. Sitemap: https://tuodominio.it/sitemap_index.xml |

| 4 | Usa un file robots.txt separato per ogni sottodominio Ogni dominio e sottodominio deve avere il proprio file robots.txt. Le regole scritte su www.tuosito.it non valgono per blog.tuosito.it o shop.tuosito.it.

|

| 5 | Rispetta il case corretto per i nomi degli user-agent I nomi degli user-agent sono case-sensitive. Googlebot è corretto, mentre googlebot, GoogleBot o GOOGLEBOT non verranno riconosciuti.Usa sempre il nome esatto dichiarato dal motore di ricerca. |

| 6 | Conosci quali user-agent ogni motore di ricerca rispetta Google ha diversi crawler ma riconosce solo le regole indirizzate a:

Verifica sempre a quali user-agent vanno indirizzate le tue regole. |

| 7 | Controlla quali direttive vengono effettivamente supportate Non tutti i crawler rispettano tutte le direttive. Ad esempio:

Consulta sempre le linee guida ufficiali dei motori di ricerca prima di scrivere le regole. |

Considerazioni finali

Il file robots.txt, per quanto spesso sottovalutato, rappresenta un elemento strategico nella gestione dell’indicizzazione e della scansione di un sito web. Non si tratta solo di una configurazione tecnica: è uno strumento che, se usato con consapevolezza, può migliorare le performance SEO, evitare errori gravi e proteggere sezioni riservate.

Scrivere un file robots.txt efficace richiede attenzione, conoscenza dei crawler, comprensione delle direttive supportate e consapevolezza di come i motori di ricerca interpretano le regole. Se non sei sicuro di come configurarlo nel modo giusto, è meglio affidarsi a un professionista.

Richiedi una consulenza personalizzata

Dalla configurazione del file robots.txt alla gestione completa dell’indicizzazione: se hai dubbi o vuoi migliorare le prestazioni SEO, possiamo aiutarti. Analizziamo il tuo sito e ti proponiamo una strategia su misura.

FAQ - Domande e Risposte

Il file robots.txt serve a comunicare ai crawler dei motori di ricerca quali parti del sito possono essere esplorate e quali devono essere evitate. Non impedisce l’indicizzazione di una pagina, ma può limitarne la scansione per evitare sovraccarichi o proteggere aree riservate.

Questo messaggio indica che Google ha trovato e indicizzato l’URL (magari tramite link esterni), ma non ha potuto analizzarne il contenuto perché il file robots.txt ne blocca la scansione. Il risultato è che la pagina potrebbe apparire nei risultati con titolo ma senza descrizione.

Disallow impedisce la scansione, ma non l’indicizzazione se la pagina è linkata da altri siti. Il tag noindex, invece, blocca l’indicizzazione, ma funziona solo se la pagina viene effettivamente scansionata. Per rimuovere davvero una pagina dai risultati di ricerca, serve il tag noindex.

In teoria sì, ma in pratica no. I bot legittimi rispettano le regole del robots.txt, ma quelli malevoli spesso le ignorano. Per proteggere il sito da scraper o bot dannosi, è meglio usare strumenti server-side come firewall, regole .htaccess o servizi anti-bot.

No, non è obbligatorio. Se non viene trovato, i crawler assumeranno che possano scansionare tutte le pagine del sito. Tuttavia, averlo è fortemente consigliato per controllare il comportamento dei bot, soprattutto su siti complessi o con sezioni riservate.

Non ci sono limiti rigidi imposti, ma Google consiglia di mantenere il file sotto i 500 KB. È comunque buona pratica organizzare le regole in modo chiaro, evitare ripetizioni e testarne il funzionamento tramite strumenti ufficiali come la Google Search Console.

Questo articolo ti è stato utile?

Ciro Scopece

SEO Specialist e sviluppatore WordPress con oltre 5 anni di esperienza nella realizzazione di siti performanti e ottimizzati per la Ricerca Google. Partner certificato Google Ads.

Pesaro web

Pesaro web